- Регистрация

- 9 Май 2015

- Сообщения

- 1,071

- Баллы

- 155

- Возраст

- 51

Генеральный директор Tesla и основатель OpenAI Илон Маск на прошлой неделе предположил, что человечество может свести на нет свой страх перед восстанием машин (то есть роботов) за счет слияния с этими самыми машинами и превращения в киборгов. Однако современные тенденции в области искусственного интеллекта, заточенного сугубо под программное обеспечение, и технологии глубокого обучения вызывают серьезные сомнения в почве такого заявления, особенно в долгосрочной перспективе. И связано это не только с аппаратными ограничениями, но и с ролью человеческого мозга в этом всем.

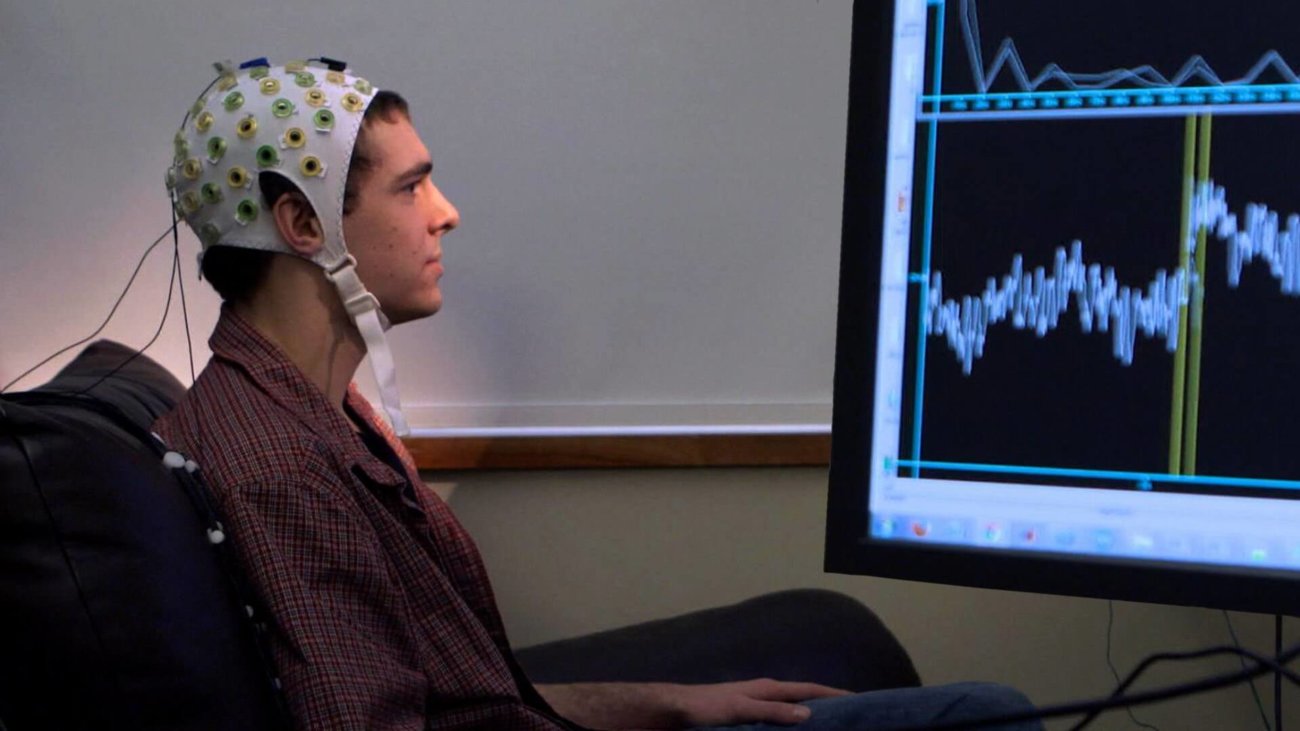

Тезис Маска весьма прямолинеен: достаточно развитые нейрокомпьютерные интерфейсы позволят людям массово увеличить свои возможности, лучше использовать такие технологии, как машинное обучение и глубокое обучение. Но такой обмен будет двусторонним. Нейрокомпьютерные интерфейсы помогут также заполнить пробелы в алгоритмах машинного обучения за счет людей, например, при принятии контекстуальных решений. Идея сама по себе не нова. Ликлайдер и другие размышляли о возможности и последствиях «симбиоза человека и компьютера» в середине 20 века.

Прогресс шел медленно. Не в последнюю очередь из-за развития аппаратного обеспечения. «Если причина, почему hardware (аппаратное обеспечение) так называется — потому что оно hard (трудное)», говорил Тони Фаделл, создатель iPod. А создать аппаратное обеспечение, которое будет связано с органическими системами, будет еще труднее.

Современные технологии примитивны, если сравнивать их с изображениями нейрокомпьютерных интерфейсов в научно-фантастических фильмах вроде «Матрицы».

Причуды глубокого обучения

Если предположить, что аппаратная проблема будет в конечном счете решена, остаются и другие проблемы. Последнее десятилетие невероятных достижений в области исследований глубокого обучения показало, что некоторые препятствия преодолеть не так-то и просто.

Во-первых, мы просто не понимаем и не можем описать, как именно функционируют сложные нейронные сети. Мы доверяем простой технологии вроде калькулятора, потому что знаем, что она всегда будет точно делать то, что мы от нее хотим. Его ошибки — это почти всегда результат ошибочных действий со стороны человека.

Например, мы хотели бы, чтобы дополнение нас машиной позволило бы нам стать совершенными в арифметике. Чтобы вместо того, чтобы доставать калькулятор или смартфон, мы могли бы подумать о расчете и получить мгновенный ответ от вспомогательной машины.

Все становится сложнее тогда, когда мы пытаемся подключить более сложные функции, предлагаемые методами машинного обучения. Например, глубокое обучение.

Допустим, вы работаете сотрудником безопасности аэропорта и ваш мозг дополняет машина, которая автоматически сканирует тысячи лиц, которые вы видите ежедневно, предупреждая о возможных рисках для безопасности.

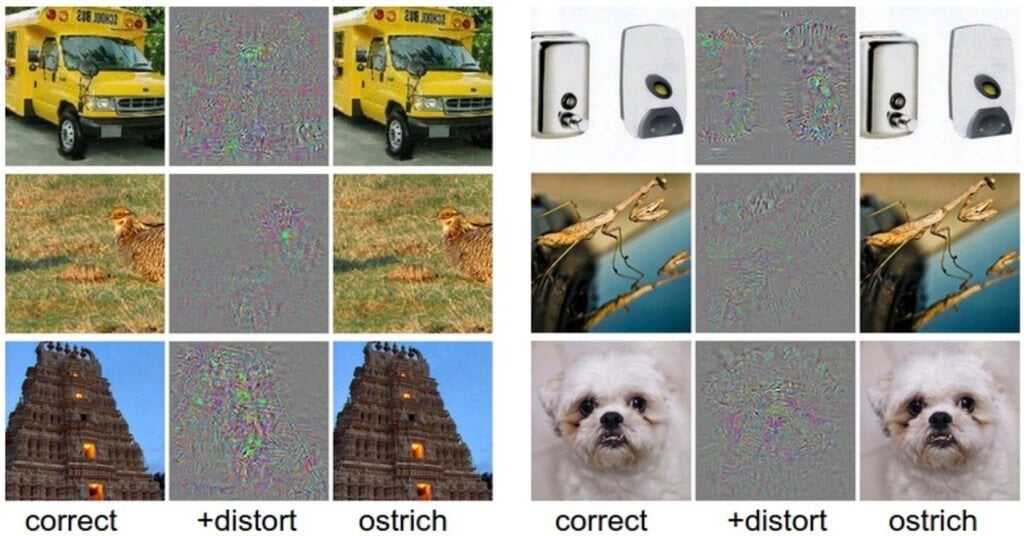

Большинство систем машинного обучения страдают от печально известной проблемы: когда крошечное изменение внешнего вида или объекта может привести к сбою в системе, не дать ей точно классифицировать объект. Измените изображение человека на 1% — и машинная система может подумать, что это велосипед.

Террористы или преступники могут использовать различные уязвимости машины, обходя проверку безопасности. Эта проблема уже мешает онлайн-безопасности. Люди, хоть и ограниченные в некотором смысле, не будут уязвимы к таким обходам.

Несмотря на то, что у машин сложилась репутация беспристрастных, технологии машинного обучения тоже страдают от предвзятости и даже могут демонстрировать расистское поведение, если ввести соответствующие данные. Эта непредсказуемость имеет серьезные последствия для того, как человек будет подключаться к машине и как будет ей доверять.

Верь мне, я робот

Доверие — это улица с двусторонним движением. Человеческая мысль — это сложная, очень динамическая деятельность. Как машине понять, какую часть человеческой предвзятости игнорировать? В конце концов, мы все сталкиваемся с ней, совершенно не отдавая себе в этом отчета. Как создать технологию, которая будет помогать вам набирать людей на работу?

В некоторой степени мы можем наблюдать вопросы доверия в нейрокомпьютерных интерфейсах, если посмотрим на то, как оборонные силы по всему миру пытаются решить вопрос доверия людей к машинам на смешанном поле боя. Люди пытаются доверять машинам, а машины — людям.

Есть параллель между боевым роботом, который принимает этическое решение проигнорировать незаконный приказ, отданный человеком, и происходящим в нейрокомпьютерном интерфейсе: машина должна интерпретировать мысли человека и отфильтровать мимолетные мысли и глубокие бессознательные предвзятости.

В оборонных сценариях логическая роль человеческого мозга будет заключаться в проверке этичности таких решений. Но как быть, когда человеческий мозг будет подключен к машине, которая способна делать логические выводы на основе данных в таких масштабах, каких ни один мозг не может охватить и понять?

В долгосрочной перспективе вопрос заключается в том, когда и как люди будут вовлечены в процессы, которые все больше определяются машинами. Очень скоро машины начнут принимать медицинские решения, которые ни один человек или команда людей не смогут понять. Какую роль тогда будет играть мозг в этом процессе?

В некоторых случаях сочетание автоматизации и работников-людей может увеличить число рабочих мест, но этот эффект будет мимолетным, скорее всего. Те же самые роботы и системы автоматизации будут улучшаться, пока не устранят созданные ими же рабочие места. Точно так же и люди, которые будут играть «полезную» роль в нейрокомпьютерных интерфейсах, будут все меньше включаться в эту цепочку, поскольку технологии будут улучшаться.

Идея сохранения актуальности человечества за счет интеграции человеческого мозга с искусственным кажется привлекательной. Но нам еще только предстоит выяснить, какой вклад будет делать человеческий мозг, если развитие технологий обгоняет развитие мозга в миллион раз.